작년 여름, 아프리카계 미국인 재키 씨는 컴퓨터 프로그램도 인종을 차별할 수 있다는 것을 깨달았습니다. 그는 다른 흑인 친구들과 콘서트에 놀러가서 찍은 사진을 구글 포토에 올렸습니다. 구글 포토에는 자동으로 이미지를 인식해 종류별로 구분해 정리하는 기능이 있죠. 그런데 그는 한 친구의 사진이 엉뚱한 폴더에 들어간 것을 보고 할 말을 잃었습니다.

구글 포토가 제 친구를 (인간이 아닌) 다른 종으로 인식했더라구요.

재키 씨는 구글 포토가 친구를 어떤 종으로 분류했는지 구체적으로 밝히지는 않겠다고 말했습니다. “그 말을 제가 다시 내뱉으면 그런 인식을 강화하는 느낌이 들어서요.” 재키 씨 외에도 피부색이 어두운 구글 포토 사용자 여럿이 비슷한 문제를 경험했습니다. 재키 씨는 이것이 단순한 기술적 결함이 아니라고 생각합니다.

컴퓨터를 누가 만들었나요? 프로그램을 훈련시킨 게 누구죠?

프로그램 개발자 중 흑인이 없었을 거라는 게 그의 추측입니다.

구글 측은 다양한 인종을 대상으로 프로그램을 시험했으나 기술이 아직 초기 단계로 발전 중이라며, 벌어진 일에 대해 사과했습니다. 하지만 재키 씨의 경험은 데이터를 활용하는 컴퓨터 알고리즘이 드러내는 여러 편견 중 일부일 뿐입니다. 많은 분들이 넷플릭스나 아마존의 추천 시스템을 유용하게 쓰고 계실 겁니다. A라는 영화를 좋아한다고 하면, 당신이 좋아할 만한 다른 영화들을 추천해주는 시스템이죠. 이는 <터미네이터>를 좋아하는 사람들은 대부분 <엑스마키나>도 좋아하더라는 식의 데이터가 축적된 덕에 가능한 것입니다.

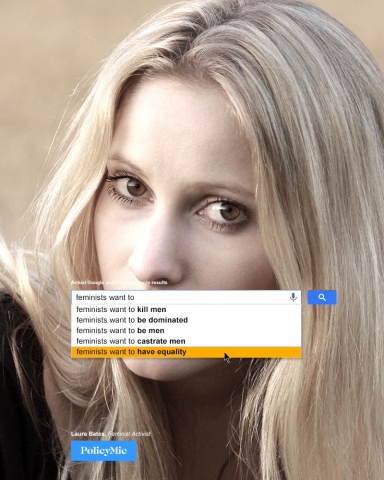

하지만 이 같은 사용자 피드백은 사회적인 편견을 강화시킬 수도 있습니다. 몇 해 전 하버드대학에서 나온 연구에서는 구글에 '아프리카계 미국인스러운' 이름을 넣어 검색하면 범죄자 정보를 찾아주는 회사 광고가 뜰 가능성이 높다는 사실이 밝혀졌습니다. 검색 데이터가 축적됨에 따라, 알고리즘도 검색 엔진 사용자들이 갖고 있는 편견을 그대로 반영하게 된 것입니다. 기계가 사용자들의 편견을 학습하고, 이에 따라 광고를 더 노출시켜 다시 사용자들의 편견을 강화하는 악순환이 생겨나는 것이죠.

또한 여성 사용자에게는 급여가 적은 일자리 광고가 더 많이 뜬다는 연구 결과도 있습니다. 한 전문가는 여성들이 스스로 인식도 못한 채 검색 엔진의 편견을 강화시켜주고 있다고 말합니다.

여성이 실제로 급여가 높은 일자리 광고를 클릭하지 않는 것일 수 있습니다. 하지만 이는 오랜 세월 여성이 남성에 비해 낮은 급여를 받아왔기 때문에 어차피 급여가 높은 일자리에 지원했다가는 떨어질 게 뻔하다는 인식이 뿌리를 내렸기 때문일지도 모릅니다.

전문가들이 우려하는 점은 이러한 알고리즘의 활용 범위가 점점 더 넓어지고 있다는 것입니다. 펜실베니아 주에서는 어떤 범죄에 어떤 형량을 적용할지를 일부 컴퓨터 알고리즘으로 결정하는 방안을 검토 중이고, 입사 지원자의 범위를 좁히기 위해 알고리즘을 활용하고 있는 기업들도 있습니다.

기계는 데이터 인풋에 기반해 스스로 규칙을 만들어나가는데, 그렇게 해서 나온 아웃풋이 때로는 우리가 인식도 못한 편견을 반영하기도 하죠.

미시간대학 크리스천 샌드빅(Christian Sandvig) 교수의 설명입니다. 하지만 그는 알고리즘이 품고 있는 편견을 바로잡고, 기술을 긍정적인 방향으로 활용하는 것이 가능하다고 믿습니다. 이미 채용 과정에서 인간의 편견을 배제할 수 있도록 지원하는 앱이 출시되기도 했죠. 프로그램을 고칠 수 있는 것은 다름아닌 인간이기 때문에, 인간이 지속적으로 이 문제에 대해 이야기를 나눠야 한다고 샌드빅 교수는 주장합니다.

원문 : NPR